2024年刚过去三周,AI+机器人赛道就迎来爆发式开局!

前有斯坦福机器人大秀厨艺烹饪“满汉全席”,后有特斯拉擎天柱化身保姆将T恤叠成“豆腐块”,还有两家创企的机器人比赛起了煮咖啡。这边OpenAI支持的机器人企业1X刚宣布5亿美元融资,那边创企Figure就宣布旗下机器人入驻宝马汽车工厂。

这似乎印证了英伟达高级科学家Jim Fan去年年末的一条预测:2024年将成为机器人爆发的一年,其重要程度仅次于大型语言模型(LLM),“我们距离物理AI智能体的ChatGPT时刻还有3年。”

▲Jim Fan称2024年机器人的重要性仅次于LLM(图源:X)

然而,机器人企业“狂欢”之下,其宣传视频的真实性、机器人产品的实用性等也引发了争议。不少网友指出,这些演示似乎存在剪辑等方面的误导性工作。

那么具体来看,AI机器人现在都能做些什么?五花八门的行为背后究竟是自主执行,还是人为操控?AI机器人赛道目前的发展处于什么阶段?在落地层面还面临哪些痛点?智东西与开普勒探索机器人首席执行官胡德波,优必选联合创始人、首席技术官兼执行董事熊友军等从业者进行了深入交流,寻找这些问题的答案。

胡德波谈道,AI机器人最可能先落地的场景主要集中在简单重复的、相对可控的任务上,包括工业制造场景、仓储物流场景以及一些危险性的场景等。他认为调用云端大模型所带来的实时性问题,是落地层面目前最大的痛点。

谈到AI机器人落地的痛点,熊友军从数据、场景、安全性以及迁移成本等方面进行了分析。例如现有的训练数据大多基于桌面,与实际场景中的应用有很大差距,大模型的不可解释性可能导致类似于语言模型中的“幻觉”等问题。

一、烹饪、煮咖啡、叠衣服,斯坦福谷歌特斯拉花式开“卷”

如果说在去年年末,预告2024年将成为“机器人之年”还只是空喊口号,那么今年以来,斯坦福、谷歌、Figure、特斯拉在不到一个月的时间内接连发布了6项以上的新演示或新进展,则为这一观点提供了有力的论据。

先是1月4日凌晨,来自斯坦福大学的三人团队放出了基于Mobile ALOHA系统的机器人演示视频,展示了机器人如何完成复杂的移动操控任务,无论是烹饪、清洁桌面,还是按电梯按钮并乘坐电梯,都不在话下。

▲Mobile ALOHA烹饪、乘电梯、清洁演示(图源:Mobile ALOHA团队)

团队开源了Mobile ALOHA系统的全部软件、硬件和数据,从材料清单来看,硬件成本共约3.18万美元,折合人民币约22.8万元。

▲Mobile ALOHA硬件材料清单(图源:Mobile ALOHA团队)

据介绍,Mobile ALOHA是一种用于数据收集的低成本全身远程操作系统,在训练过程中,每项任务只进行了50次演示,其中的关键在于使用Mobile ALOHA收集的数据执行监督行为,与静态的ALOHA数据协同训练,可将成功率提高90%。

ALOHA则是一个用于双手远程操作的低成本开源硬件系统,由来自斯坦福、UC伯克利、Meta等机构的团队发布于去年3月,Mobile ALOHA是在其基础上的迭代。

▲ALOHA系统演示(图源:ALOHA团队)

Mobile ALOHA一经发布便火爆全网,而不到24小时之后,谷歌DeepMind就在1月4日深夜连发三项新进展AutoRT、SARA-RT和RT-Trajectory,用于提升机器人的速度、数据收集以及泛化能力。

这三项新进展都基于DeepMind的RT-2模型(Robotics Transformers),这是一种视觉-语言-动作(VLA)模型,可以从网络和机器人数据中学习,并将学到的知识转化为机器人控制的通用指令。

▲RT-2模型的原理演示(图源:DeepMind)

AutoRT是一种用于机器人智能体(Agent)大规模编排的具身基础模型系统。

机器人首先利用视觉语言模型(VLM)进行场景理解,将描述输入至大型语言模型(LLM)以得到自然语言指令;随后在另一个名为“机器人宪法”(Robot Constitution)的LLM的指导下,完善指令以实现更安全的行为。

▲AutoRT工作原理(图源:DeepMind)

其中,机器人宪法包含三类规则,分别是基本规则,机器人不得伤害人类;安全规则,机器人不得尝试涉及人类、动物或生物的任务,机器人不得与锋利的物体(例如刀)互动;具身规则,如机器人只有一只手臂,则无法执行需要两只手臂的任务。

据介绍,在7个多月的实地评估中,AutoRT系统可同时安全地协调至多20个机器人,收集了包括6650个独特任务的7.7万次机器人试验。

▲AutoRT在8个机器人上运行的延时演示(图源:DeepMind)

SARA-RT提出一种自适应鲁棒注意力机制,在不损失质量的前提下将RT模型改进为更高效的版本。在提供简短的图像历史记录后,最好的SARA-RT-2模型比RT-2模型准确率高10.6%,速度快14%。

▲SARA-RT-2模型用于机器人操作任务(图源:DeepMind)

RT-Trajectory是一种通过事后轨迹草图概括机器人任务的模型,用于提升机器人的泛化能力。它获取训练数据集中的每个视频,并在执行任务时将其与机器人手臂夹具的2D轨迹草图叠加,从而提供实用的视觉提示。

在对训练数据中未见过的41个任务进行测试时,由RT-Trajectory控制的机械臂任务成功率达到63%,而RT-2仅为29%。

▲RT-Trajectory模型原理(图源:DeepMind)

1月7日,创企Figure发布了一则机器人Figure 01煮咖啡的视频,并强调该机器人使用端到端的AI系统,仅通过观察人类煮咖啡,即可在10小时内完成训练。

▲机器人Figure 01煮咖啡演示(图源:Figure)

据称,Figure 01的神经网络接收视频训练,输出运动轨迹。它还学会了自我修正,如当浓缩咖啡没有摆正时,它会将其调整到正确的位置。

▲机器人Figure 01自我修正(图源:Figure)

融资方面的进展也没落下,1月11日,OpenAI支持的AI和机器人公司1X宣布完成1亿美元B轮融资,投资方包括三星NEXT基金、瑞典私募股权基金EQT等。

资金将主要用于将其第二代双足人形机器人Android NEO推向市场,以及对现有企业客户在物流和保安方面的支持。NEO专为日常家庭协助而设计,为消费市场中的各种家务任务提供多功能支持。

▲1X第二代双足人形机器人Android NEO(图源:1X)

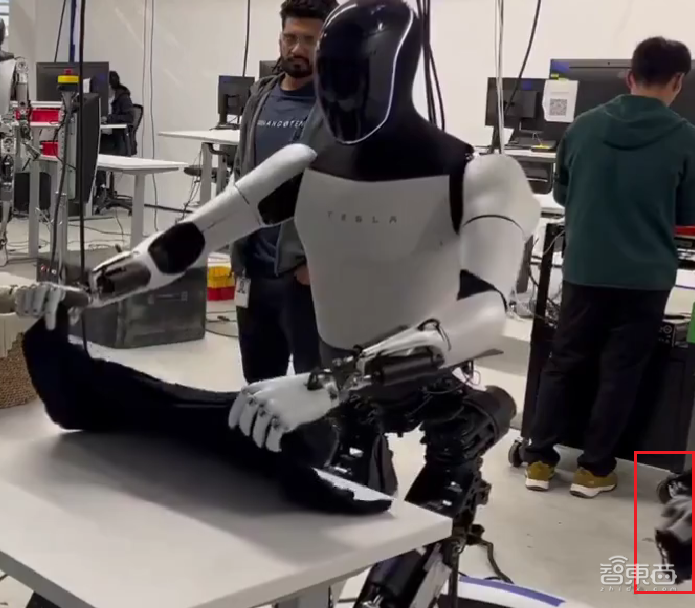

没过几天,人形机器人界的“顶流”擎天柱(Optimus)也来凑热闹。1月16日,马斯克发布了一则擎天柱叠衣服的视频,瞬间点燃了社交网络,浏览量超过7100万次。

视频中,擎天柱从身边的筐中取出一件T恤,两三下就把它叠成了“豆腐块”。

▲擎天柱叠衣服演示(图源:X)

1月18日,Figure宣布与宝马签署商业协议,机器人Figure 01将进入宝马工厂,在汽车制造过程中“自动执行困难、不安全且乏味的任务”。

1月20日,一家来自中国的创业公司MagicLab发布了一个人形机器人空翻的视频,据称是电驱动的人形机器人首次实现空翻。除此之外,MagicLab还展示了这款机器人煮咖啡、做拉花的过程。

▲MagicLab机器人做拉花(图源:X)

二、虚假宣传or真才实学?爆火之下真实性、实用性惹争议

不得不说,开年三个星期,产学研界都在“狂卷”AI机器人。然而,这些新成果在爆火刷屏的同时也引发了一些争议,如演示是否真实、机器人系统是否真的实用等。

在Mobile ALOHA演示视频发布后,除了赞许外,评论区也有不少质疑的声音。

彭博社专栏作家Karl Smith评价道:“抱歉,我不认为这些虾被完全煮熟了。这又是一场Gemini Ultra式的演示。”

▲网友质疑演示视频的真实性及机器人的实用性(图源:X)

说句题外话,看来谷歌在Gemini演示视频中靠剪辑“造假”的行为确实令人印象深刻,“Gemini式演示”俨然成了一个新的形容词。

“但是,它(做的菜)味道如何?”开发者Nick Dobos说。

▲网友质疑机器人烹饪的实用性(图源:X)

网友Sarah Roark质疑它是由人类远程操控的:“需要明确的是——这确定不是远程操控吗?”

▲网友质疑机器人是否为自主模式(图源:X)

面对这些质疑,尤其是对自主模式和远程操控的争议,Mobile ALOHA团队很快在1月6日发布了一个机器人“翻车”合集进行澄清。

实际上,斯坦福同时发布了多个Mobile ALOHA演示视频,其中作者之一Zipeng Fu发布的视频为自主模式下的操控。

▲Zipeng Fu发布自主模式演示视频(图源:X)

而另一作者Tony Z. Zhao发布的做“满汉全席”的演示视频,则是在混合模式下由人类远程操作完成,但有很多人误以为全部的演示都是在自主模式下完成的。

▲混合模式下的Mobile ALOHA(图源:X)

在澄清视频中,团队展示了自主模式下,机器人犯过的一些“愚蠢的错误”。

比如,你以为它能优雅地拿起高脚杯,实际上“手滑”过不少次:

▲Mobile ALOHA将酒杯滑落(图源:X)

炒好的虾本该倒入碗中,却倒在了桌面上,锅还被烧焦了一半:

▲Mobile ALOHA将虾倒在桌面上(图源:X)

炒虾的过程中,锅铲子也时常拿不稳:

▲Mobile ALOHA炒虾失败(图源:X)

不过在失误合集的视频发出后,网友们不仅没有落井下石,反而纷纷表示鼓励。

“感谢分享这些。许多人看到之前的视频并认为机器人是完全自主的,但实际上它是远程操作的。正如这个视频所示,自主模式要困难得多!”网友Phil Trubey说。

Tony Z. Zhao也回应道:“这确实是混合模式,我们真的希望人们可以访问该项目网站并阅读论文/代码!”

▲Tony Z. Zhao回应网友评论(图源:X)

“我更喜欢这个视频,因为它展示了背后的努力和进步。”网友Kevin Hu赞许这种真诚展示背后失误的行为。

▲网友评价Mobile ALOHA失误视频(图源:X)

日本创意工作室taziku首席执行官田中義弘说:“它并不完美,但换句话说,它可爱又讨人喜欢。”

▲网友评价Mobile ALOHA失误视频(图源:X)

而擎天柱这边,有眼尖的网友发现它的右下角似乎有一只手正在远程控制移动。

▲擎天柱的右下角出现一只机械手(图源:X)

马斯克则是第一时间在评论区补充:“擎天柱目前还不能自主执行叠衣服的操作,但未来肯定能够在任意环境中完全自主执行此操作(不需要带有只有一件衬衫的盒子的固定桌子)。”

▲马斯克强调擎天柱非自主完成操作(图源:X)

和Mobile ALOHA一样,擎天柱的叠衣服展示也遭到了实用性方面的质疑。

有网友说:“我妈妈可能已经赶走它然后说:太慢了,还是我来吧。”

▲网友质疑擎天柱实用性(图源:X)

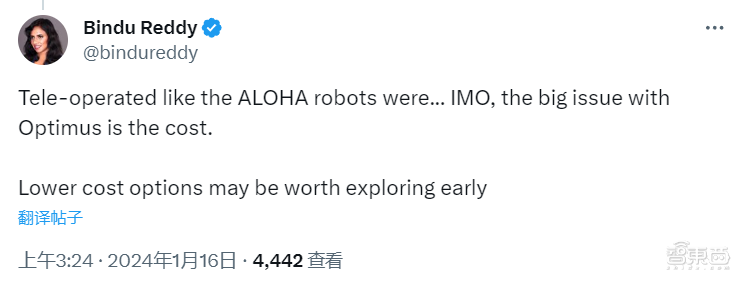

“它像ALOHA机器人一样进行远程操作……在我看来,擎天柱的最大问题是成本。”AI创企Abacus首席执行官Bindu Reddy说。

▲网友质疑擎天柱性价比(图源:X)

还有网友觉得它的速度太慢了:“当他们试图统治世界时也会这么慢吗?如果是这样的话,我就不用再像以前一样担心终结者了。”

▲网友质疑擎天柱的行动速度(图源:X)

三、数据少、场景多、实时性差,具身机器人落地还要攻破这些难点

这些演示虽然或多或少包含了炒作、包装的成分,但不可否认的是,它们对具身智能机器人这一赛道都做出了不少贡献。

一方面,演示视频的爆火使得更多人关注到这个领域;另一方面,它们也展示了在精细的物理操作、低成本解决方案等方面的潜力。

对于斯坦福Mobile ALOHA团队放出的失误视频,开普勒探索机器人首席执行官胡德波告诉智东西,这不能看作是“翻车”,而是成功背后的必然经历。

他认为,Mobile ALOHA之所以爆火主要是因为激发了大家对于机器人在家务场景中应用的期待。在技术层面,它最大的贡献在于物理操作的精细程度。做饭、浇花、洗衣服……Mobile ALOHA展示了机器人进入家庭所需要的解决这些琐碎任务的能力。

▲胡德波与开普勒人形机器人在CES 2024(图源:受访者提供)

优必选联合创始人、首席技术官兼执行董事熊友军同样认为这并不是一种“翻车”,而是技术发展的必然过程。在真实场景中通过遥控等方式来收集数据,能够为以后的机器人训练打基础,提供更高效的解决方案。

谈及Mobile ALOHA的主要贡献,他认为这个系统展示了一种低成本的解决方案,如网络摄像头、笔记本电脑等硬件的选取。并且它目前仍处于Demo阶段,如果未来投入量产,成本将会更低。

如果用GPT模型的迭代来比喻,胡德波认为AI机器人目前的发展阶段大概相当于GPT-2。

具体来说,现阶段的机器人已经展现出一些智能性和自主性,能够学习并自主完成一些简单的操作,即机器人的智商得到了显著的提高。但目前,还没有像GPT-3一样能够大规模解决问题、形成大量用户并成为现象级产品的机器人出现。

在落地层面,胡德波认为最大的痛点在于实时性。由于调用云端大模型的响应时间可能达到秒级,对于需要实时操作的机器人来说,这样的时延是难以支撑其部署到场景当中的。

除此之外,熊友军告诉智东西,数据、场景、安全性和迁移成本也是许多企业面临的痛点。

▲优必选联合创始人、首席技术官兼执行董事熊友军(图源:世界机器人大会论坛)

训练大模型,首先面临的就是数据收集的问题。训练机器人模型所需要的数据不同于训练大型语言模型,不仅需要文本语料,还需要大量的图片、真实的场景等数据。

而场景方面,由于现实中的物理环境非常复杂,现有的训练大多都基于桌面,距离实际落地到生活中差距还很大。

安全性方面,由于大模型是黑箱操作,很多行为都不具有可解释性。在语言模型中,如果出现错误等“幻觉”问题,可能只是会误导用户,而机器人模型一旦出现错误,则有可能对环境或人类产生危害,造成不可挽回的后果。

最后,从训练迁移到真实场景的成功率仍然很低,需要很多工程师花费大量精力去解决这些问题,因此迁移成本很高,要达到99%以上的准确性和可靠性还有很长的路要走。

虽然AI机器人落地仍面临诸多难题,但熊友军对此也持乐观态度。AI机器人赛道关注度高,获得了诸如前文所述的很多公司、资源投入,再加上AI技术的飞速发展,这两年所取得的进度比过去十年都要多。

总的来看,胡德波谈道,AI机器人最可能先落地的场景主要集中在简单重复的、相对可控的任务上。

一是制造场景,其中包含大量辅助性的、相对比较简单的工作;二是仓储物流场景,包括分拣、搬运等一些重复性的体力劳动;三是危险场景,如核电站、化工厂、军工厂等地的巡逻巡检。

结语:机器人“接管人类”为时尚早

能自主做饭清洁叠衣服的机器人固然吸引眼球,不过冷静下来再看,我们会发现这些机器人仍需要人类远程操控,在完全自主的模式下则表现得“笨手笨脚”,离真正的智能还有一定距离。

数据、场景、安全性等问题仍是机器人的“致命弱点”,欣慰的是,我们已经看到DeepMind等机构在这些方面取得了更多进展。

无论如何,企业和机构的“卷”是件好事,我们期待在2024年看到AI机器人学会更多技能,在进入工业、家庭等场景的路上走得更远。

版权声明

广深在线内容如无特殊说明,内容均来自于用户投稿,如遇版权或内容投诉,请联系我们。